面对长上下文处理这一制约大模型发展的瓶颈,月之暗面推出的Kimi Linear架构,以一场技术革命实现了效率与性能的双重突破。

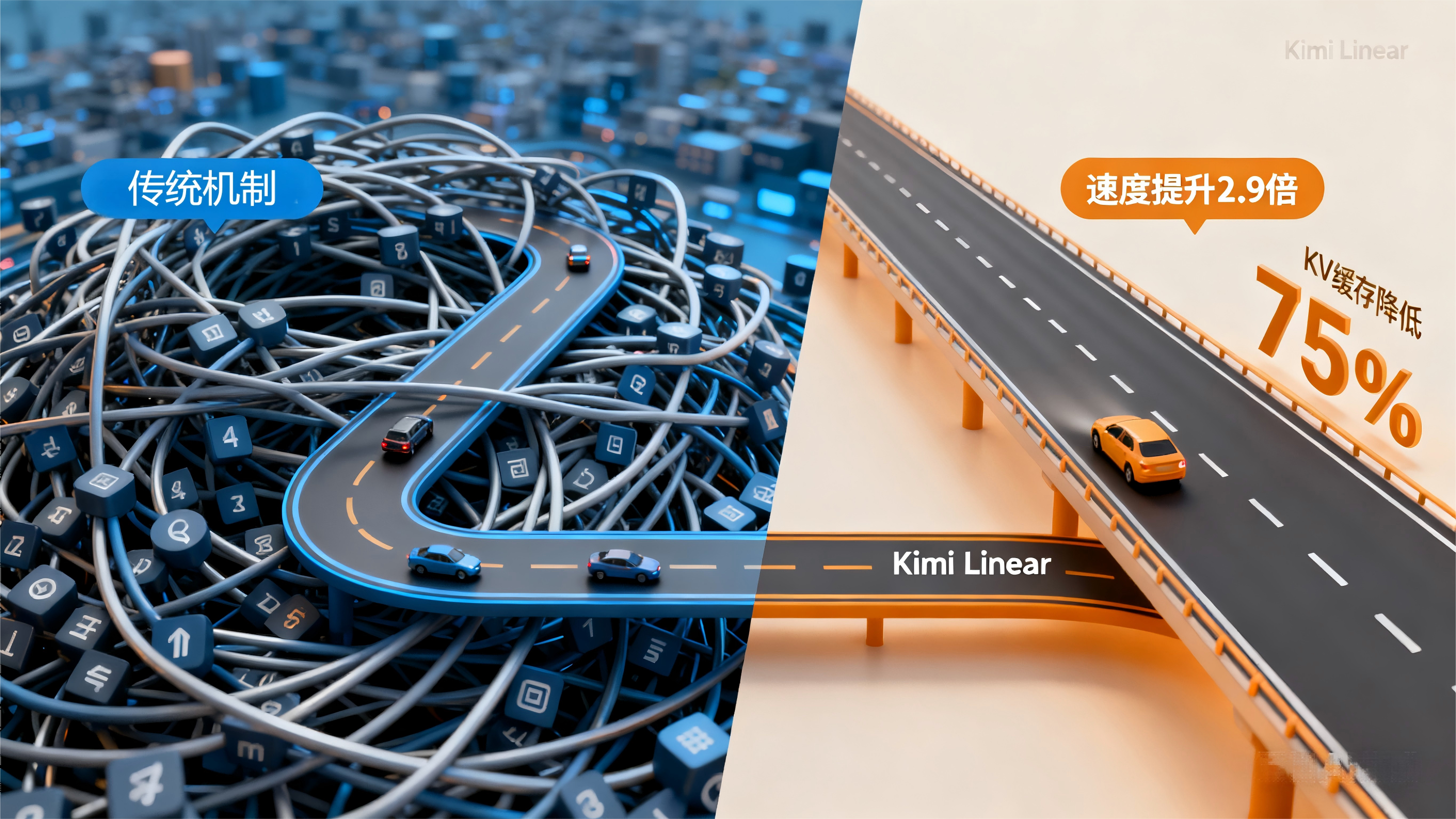

在大模型应用日益广泛的今天,传统Transformer架构在处理长文本时面临着计算效率低下的瓶颈。这一问题随着智能体(Agent)等需要长时交互应用场景的普及而愈发凸显。

近日,月之暗面团队推出的Kimi Linear混合线性注意力架构,首次在公平比较中全面超越了传统全注意力机制,为行业带来了新的解决方案。

01 突破传统瓶颈

传统的Transformer架构采用Softmax注意力机制,其计算和内存开销随着序列长度呈平方级增长。这意味着上下文长度翻倍,计算量和内存就要翻四倍。

这种二次方复杂度严重制约了模型处理长文本的能力,不仅影响推理速度,更限制了模型上下文窗口的扩展。

线性注意力机制早在2020年就被提出,通过数学变换将复杂度从O(n²)降至O(n),但早期版本在性能上始终无法与全注意力机制媲美。

月之暗面团队的研究人员发现,传统线性注意力受限于有限的状态容量,其记忆机制本质上是一个固定大小的状态,难以精确实现长序列建模和上下文检索。

02 核心创新设计

Kimi Linear的核心创新在于Kimi Delta Attention模块,这是一种全新的线性注意力机制。

KDA引入了细粒度的门控机制,为记忆的每个维度都配备了独立的遗忘旋钮,使模型能够根据输入内容,动态且精细地决定哪些信息需要保留,哪些可以遗忘。

与传统的标量遗忘门相比,这种通道级的独立遗忘率大大释放了线性注意力的潜力。

研究人员还设计了硬件高效的并行算法,采用Diagonal-Plus-Low-Rank转换矩阵的特化变体,并为此定制了分块并行算法。

这一优化使得KDA的算子效率比通用的DPLR公式高出约100%。

03 混合架构策略

Kimi Linear采用了精心设计的混合架构,整体骨干遵循Moonlight架构。

在token混合层,模型按照3:1的比例混合KDA层和全注意力层,即每3个KDA层后插入1个全注意力层。

这种设计兼顾了效率与能力——KDA层作为主力处理绝大部分序列信息,全注意力层则捕捉可能被线性结构忽略的全局依赖关系。

更为独特的是,Kimi Linear中的全注意力层不再使用位置编码。编码位置信息、建立近期偏见的责任完全由KDA层承担。

04 实验数据证明

在回文任务和多查询关联回忆等考验长上下文能力的合成任务中,KDA的表现优异。

随着序列长度从256增加到2048,KDA在所有任务中都稳定地达到了最高的准确度。

在通用知识、推理以及中文任务等多个维度的评测中,Kimi Linear几乎在所有类别中都胜出。

经过监督微调后,Kimi Linear在AIME 2025、LiveCodeBench等更困难的任务上,显著超越了基线模型。

效率提升最为明显:处理100万上下文长度时,Kimi Linear的预填充速度比传统注意力快2.9倍,解码速度更快达6倍。

同时,其KV缓存使用量减少了高达75%,大大降低了内存占用。

05 行业影响深远

Kimi Linear的突破性进展,为AI架构的发展提供了新的方向。

此前,谷歌、苹果等公司已开始探索状态空间模型等替代架构,显示出行业对超越传统Transformer的强烈需求。

月之暗面已经开源了KDA内核和vLLM实现,并发布了预训练和指令调优的模型检查点,这将促进更广泛的研究和应用。

这一技术突破为下一代智能体发展提供了高效解决方案,使模型在长时交互、复杂决策等场景中表现出更强潜力。

在技术快速迭代的人工智能领域,Kimi Linear的出现如同投入平静湖面的一颗石子,激起了层层涟漪。它证明了一点:线性注意力机制不是理论的空想,而是能够实际落地并超越传统的解决方案。

随着模型开源,月之暗面正邀请全球开发者一同验证和探索这一技术的边界。这场关于注意力机制的变革,才刚刚拉开序幕。

关注 “悠AI” 更多干货技巧行业动态

相关文章