开源模型下载量突破百万次大关,一场由30B参数掀起的轻量级AI效率革命正在重塑开发者的工具选择。

智谱AI最新开源的轻量级大语言模型GLM-4.7-Flash,在发布短短14天内于Hugging Face平台实现了下载量突破100万的里程碑。这一数字不仅创下了国产开源大模型的新纪录,更标志着全球开发社区对高效、实用AI工具的迫切需求。

作为GLM-4.7系列的轻量化版本,这款30B混合专家模型正在成为连接前沿AI研究与实际应用落地的关键桥梁。

01 技术突破

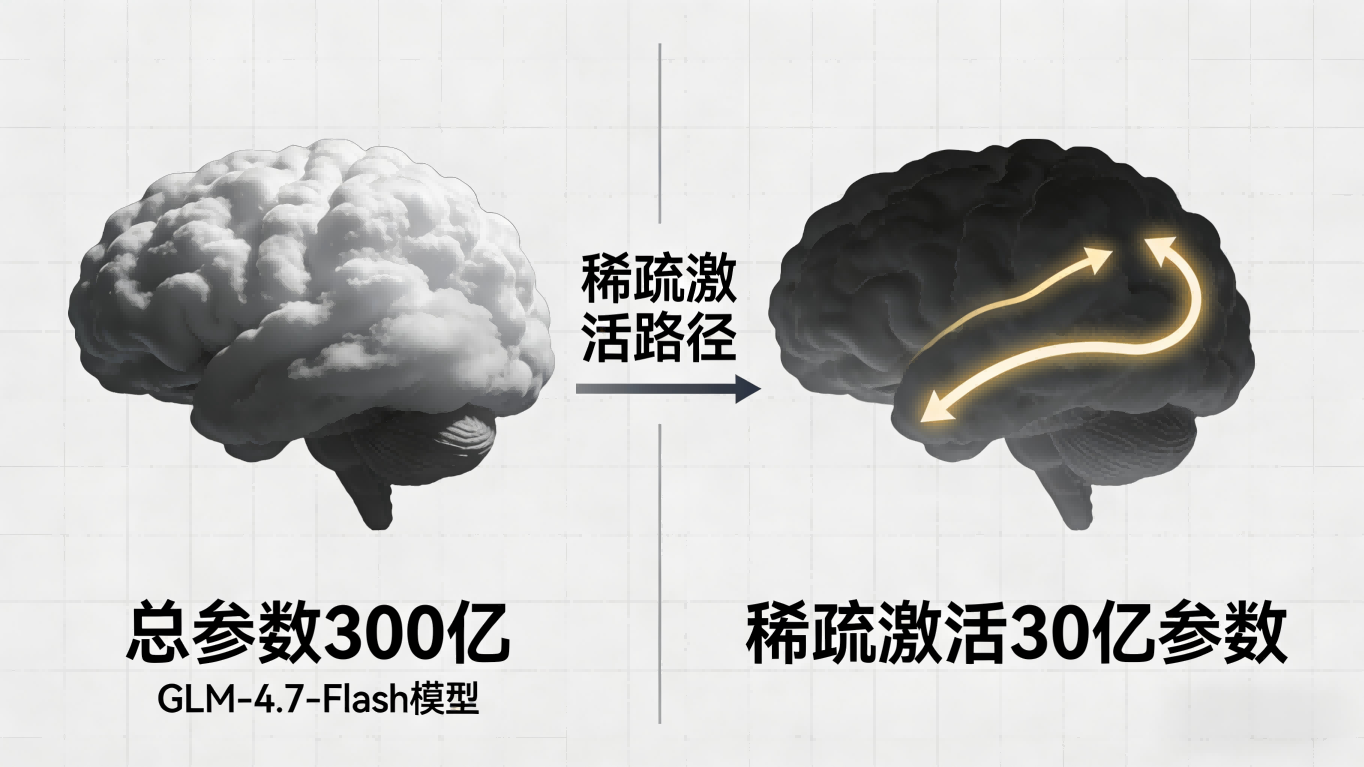

GLM-4.7-Flash采用创新的混合专家架构设计,总参数量达300亿,但在推理过程中仅激活约30亿参数,实现了性能与效率的平衡。

这种设计使模型在保持强大能力的同时,大幅降低了计算开销和部署门槛。模型还首次采用了MLA注意力机制,支持长达200K的上下文窗口,显著提升了长文本处理效率。

02 性能表现

在多项主流基准测试中,GLM-4.7-Flash展现出了令人印象深刻的性能。在SWE-bench Verified和τ²-Bench等评测中,其综合表现超越了同类尺寸的gpt-oss-20b及Qwen3-30B-A3B-Thinking-2507模型。

特别是在代码修复任务上,该模型取得了59.2的高分,在“人类最后的考试”等复杂评测中也显著领先同规模竞品。

智谱AI内部测试显示,GLM-4.7-Flash在前后端编程任务中表现卓越,同时在创意写作、翻译和角色扮演等通用场景中同样表现出色。

03 应用优势

GLM-4.7-Flash的突出优势在于其实用性和可及性。模型支持本地部署,开发者实测在配备M5芯片和32GB统一内存的苹果笔记本上,能够实现每秒43个token的推理速度。

这种性能使得个人开发者能够在有限硬件资源下运行高质量代码生成和智能体任务。官方API平台提供免费调用选项,进一步降低了使用门槛。

该模型特别优化的“交错思考”机制使其在智能体工作流中表现突出,能够根据上一步执行结果动态调整后续策略,这在复杂问题解决和多步骤任务中尤为重要。

04 行业影响

GLM-4.7-Flash两周突破百万下载的成绩,反映了开源AI模型正在获得越来越广泛的市场认可。作为GLM-4.5-Flash的直接替代品,新一代模型在性能提升的同时保持了免费开放的政策。

这一策略加速了技术的普及和生态建设,使更多开发者能够接触并使用先进的AI工具。

随着企业越来越重视数据隐私和成本控制,能够本地部署的高效模型正成为市场新宠。GLM-4.7-Flash以其优秀的性能效率比,为中小企业和个人开发者提供了高质量且经济实惠的AI解决方案。

国际AI研究社区已开始深入分析GLM-4.7-Flash的架构,其创新的“交错思考”机制和MLA注意力设计被业界视为轻量模型发展的重要方向。

智谱AI通过开放平台提供完全免费的API调用,同时支持华为昇腾NPU等多种硬件平台。这种开放性策略与两周百万下载的成绩相互印证,共同描绘出一个更加多元、可及的开源AI未来图景。

关注 “悠AI” 更多干货技巧行业动态

相关文章