小米正式开源了其首代具身智能VLA大模型——Xiaomi-Robotics-0。这个拥有47亿参数的“物理智能”引擎,不仅一举横扫了LIBERO、CALVIN等三大主流仿真测试集,更以消费级显卡即可实时推理的轻量化姿态,试图将机器人从“反应迟钝的木头人”名单中彻底除名。

长久以来,具身智能领域存在一道尴尬的鸿沟:大模型在云端博古通今,却让机器人在真实世界中像个“帕金森患者”——指令理解慢半拍,动作执行断成帧。小米此次开源的Xiaomi-Robotics-0,直指的正是这一名为推理延迟的行业死穴。

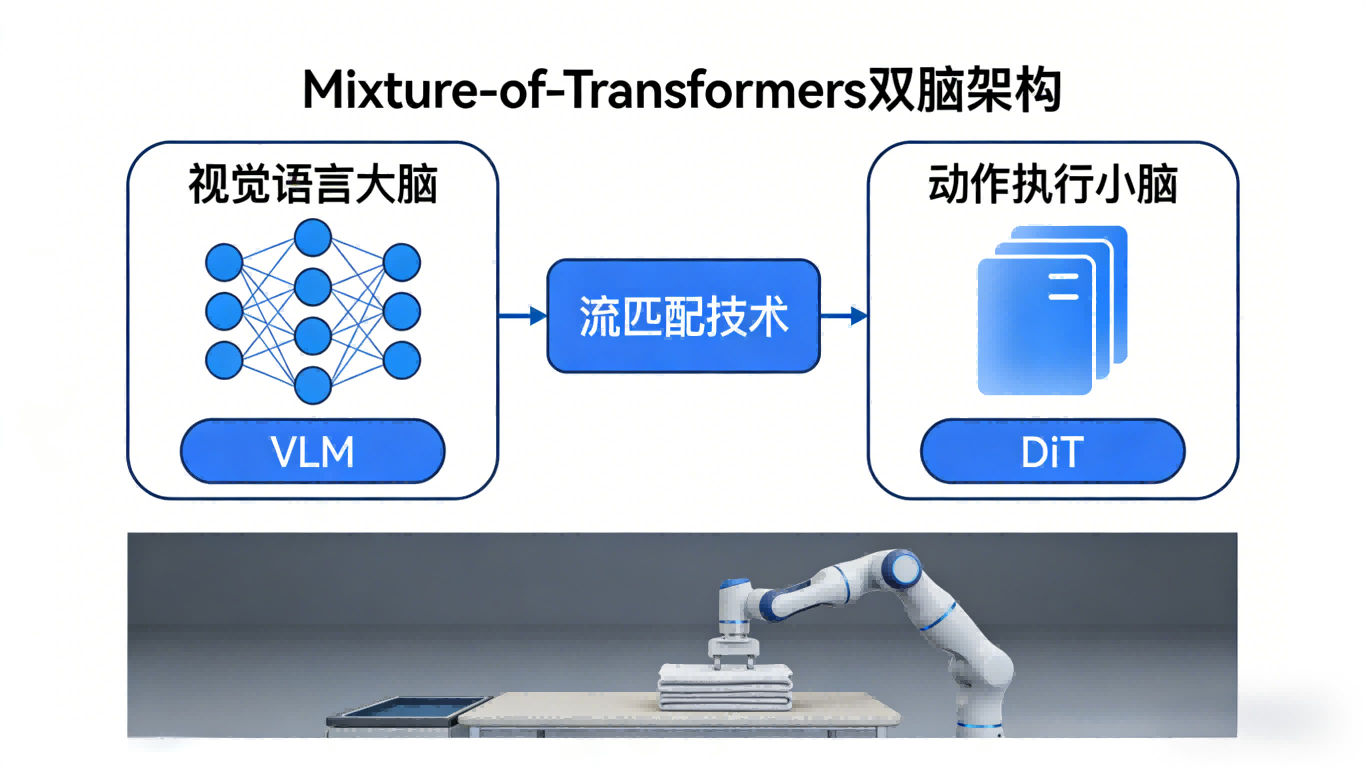

小米创始人雷军在官宣时坦言:“小米很早就布局机器人,我们会坚定推动技术开源。”这份底气来自架构层面的颠覆性创新。该模型采用了Mixture-of-Transformers(MoT)混合架构,将传统的单一大脑拆解为“双脑系统”:视觉语言大脑(VLM)负责理解模糊指令与空间关系;动作执行小脑(DiT)则专职通过流匹配技术生成高频、连续的“动作块”(Action Chunk)。

这一“解耦”设计的精妙之处在于,它让大脑可以“慢思考”,让小脑必须“快响应”。为解决真机运行时的“动作断层”问题,团队祭出了三把技术利剑:异步推理模式解除了模型推理与机器人执行的同步枷锁;Clean Action Prefix机制通过记忆前一时刻动作保障轨迹连贯;Λ-shape Attention Mask则强制模型瞪大眼睛看清眼前变化,而非沉溺于历史惯性。正是这套组合拳,让机器人在处理叠毛巾、拆积木等高自由度长时序任务时,手指“不抖了”、反应“跟手了”。

训练策略上,小米也完成了一次“知行合一”的进化。团队并未贪心一步登天,而是采用两阶段“进化论”:先在跨模态预训练阶段通过Action Proposal机制强制VLM在理解图像时同步预测动作分布,实现“纸上谈兵”到“沙盘推演”的跨越;随后冻结VLM,专项训练DiT从噪声中恢复精准动作序列,让模型既保留博学的常识,又练出敏捷的体魄。

数据显示,在与30余款主流模型的正面交锋中,Xiaomi-Robotics-0在全部Benchmark中拿下当前最优(SOTA)成绩。但比榜单数据更具温度的,是真机视频里那台双臂机器人——面对软塌塌的毛巾,它不再像以往那样生硬地“铲”或“戳”,而是像人一样轻捏、提起、折叠,手眼协调间透着一股“从容”。

更具行业震动意义的是小米的开源姿态。此次,技术主页、GitHub代码库、Hugging Face模型权重已全量开放。这意味着,任何拥有一块消费级显卡的开发者,都不必再仰望大厂动辄千万级的专业算力集群。物理智能的技术民主化,正在从口号变为桌面上可下载的文件。

从汽车工厂里的六七百台工业机器人,到今天开源的人形机器人大脑,小米在“双足落地”与“代码上天”之间画出了一条清晰的路径。当这家公司把最核心的VLA模型像MIUI一样交给全球极客时,具身智能的ChatGPT时刻,或许真的不远了。

关注 “悠AI” 更多干货技巧行业动态

相关文章