人工智能领域的国际顶级学术会议AAAI 2026近日收录了一项突破性研究,摩尔线程提出的URPO框架成功将大模型的“生成”与“评判”能力合二为一,为AI训练领域带来全新变革。

通过将“指令遵循”和“奖励评判”两大角色融合在单一模型中,URPO框架实现了训练效率与模型性能的双重提升。

实验数据显示,采用该框架的模型在指令跟随、综合推理等关键能力上均取得显著进步,其内部涌现的评判能力甚至超越了专用奖励模型。

01 突破传统训练框架

人工智能技术的迅猛发展背后,大语言模型的训练过程一直面临着效率与性能难以兼顾的挑战。

传统训练方法通常需要独立的奖励模型来指导生成模型优化,这种分离架构不仅增加了训练复杂性,也限制了模型性能的进一步提升。

11月13日,摩尔线程AI研究团队宣布其提出的URPO(统一奖励与策略优化)框架被人工智能领域的国际顶级学术会议AAAI 2026收录。

这一框架的创新性在于打破了传统训练中生成与评判分离的架构限制。

在题为《URPO:A Unified Reward & Policy Optimization Framework for Large Language Models》的论文中,研究团队详细阐述了这一统一奖励与策略优化框架。

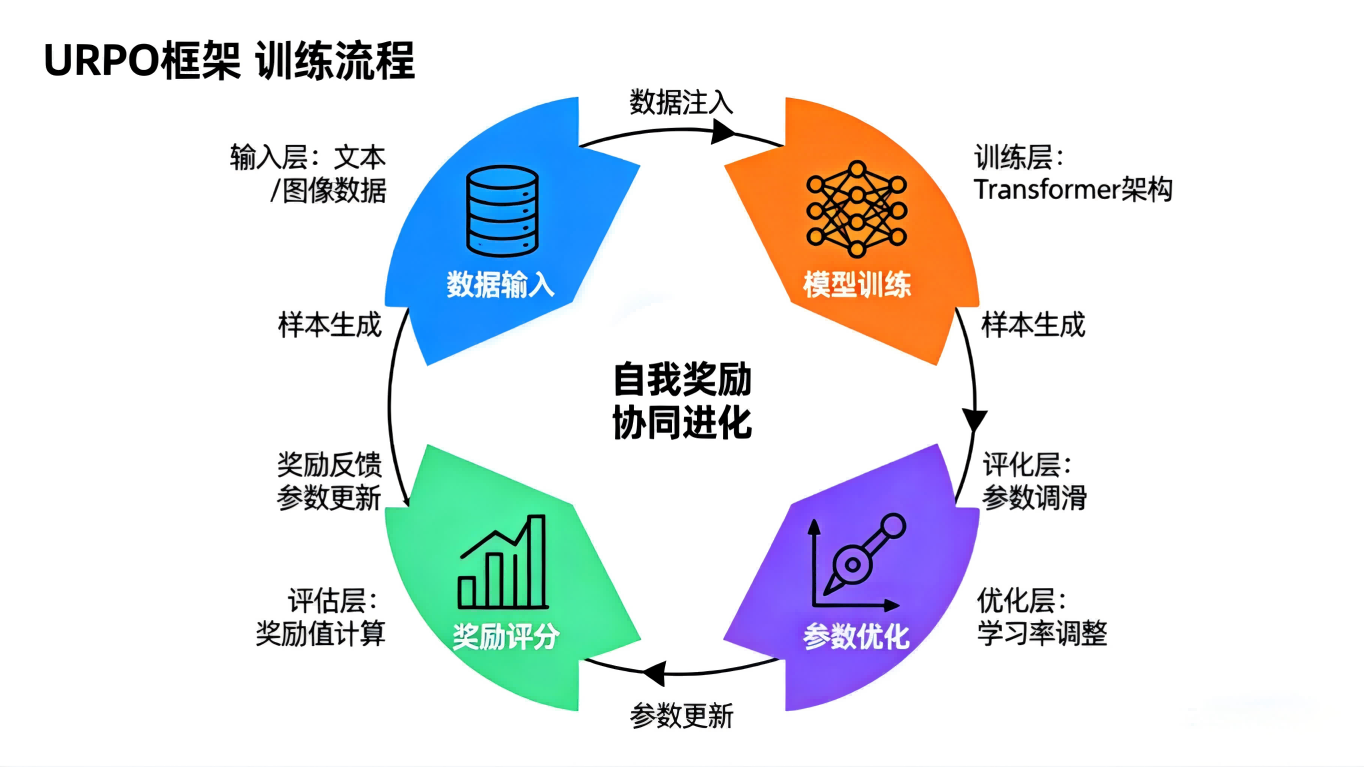

该框架将“指令遵循”(选手)和“奖励评判”(裁判)两大角色融合于单一模型中,并在统一训练阶段实现同步优化。

02 三大技术突破

URPO框架的成功归因于三大核心技术突破,这些技术攻克了当前大模型训练领域的关键挑战。

数据格式统一成为基础。研究团队将异构的偏好数据、可验证推理数据和开放式指令数据,统一重构为适用于GRPO训练的信号格式。

这一步骤解决了不同类型数据在训练过程中的兼容性问题。

自我奖励循环机制的建立让模型拥有了自我改进的能力。针对开放式指令,模型生成多个候选回答后,自主调用其“裁判”角色进行评分。

评分结果随后作为GRPO训练的奖励信号,形成一个高效的自我改进循环。

协同进化机制确保了生成能力与评判能力的双向提升。通过在同一批次中混合处理三类数据,模型的两种能力得以协同进化。

生成能力提升带动评判更精准,而精准评判进一步引导生成质量跃升,从而突破静态奖励模型的性能瓶颈。

03 实验数据证实有效性

研究团队通过一系列严谨实验验证了URPO框架的有效性。基于Qwen2.5-7B模型的测试结果显示,URPO框架多项性能指标超越传统基线。

在AlpacaEval指令跟随榜单上,采用URPO框架的模型得分从42.24提升至44.84。

这一提升表明模型在理解并遵循人类指令方面取得了明显进步。

在综合推理能力测试中,平均分从32.66提升至35.66,显示出框架对模型逻辑思维能力的显著增强。

更为引人注目的是,作为训练的“副产品”,该模型内部自然涌现出的评判能力在RewardBench奖励模型评测中取得85.15的高分。

这一表现甚至优于其替代的专用奖励模型(83.55分),证明了URPO框架的卓越性能。

04 应用前景广阔

技术落地应用是衡量研究成果价值的重要标准。摩尔线程已在其自研计算卡上实现了URPO框架的稳定高效运行。

同时,公司已完成与VERL等主流强化学习框架的深度适配,为该技术的广泛应用奠定基础。

URPO框架的提出不仅简化了大模型训练流程,还突破了对独立奖励模型的依赖,为更多研发机构提供了新思路。

这一创新尤其适用于需要快速迭代的开发场景,可能引发大模型训练范式的变革。

随着技术文档的逐步公开,预计将有更多研究机构和企业开展相关实验验证,进一步挖掘URPO框架的潜力与价值。

URPO框架的技术突破不仅标志着摩尔线程在大模型训练领域的领先地位,更展现了一种全新的AI发展路径。

当模型既能生成答案,又能评价答案,我们离真正智能的机器似乎又近了一步。

随着AAAI 2026会议的临近,业界正密切关注这一技术如何重塑未来AI训练的生态图景。

关注 “悠AI” 更多干货技巧行业动态

相关文章