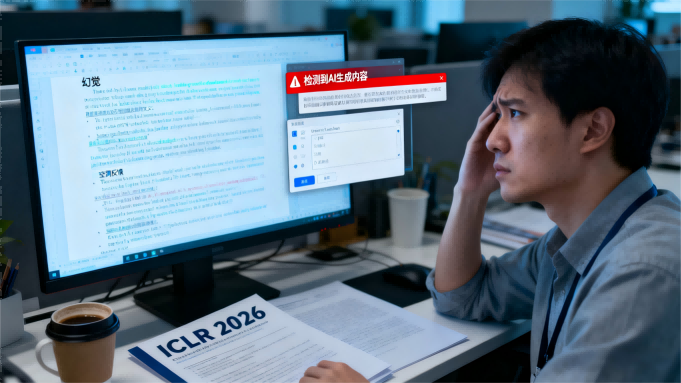

一本正经地指出你论文中根本不存在的错误,用冗长而空洞的评语包裹着少数有效建议,这不是初出茅庐的审稿人,而是AI生成的审稿意见。

“评审意见非常啰嗦,满是要点,却要求进行非标准的统计分析。”美国卡内基梅隆大学的AI研究员格雷厄姆·诺伊比格道出了许多国际学习表征大会(ICLR)投稿人的共同困惑。

在社交媒体上,数十名学者纷纷吐槽收到的评审中出现了“幻觉”引用和异常含糊不清的反馈。

一场席卷全球顶尖AI学术会议的AI代写风波正悄然袭来,而这场风暴的中心,恰恰是那些本应捍卫学术质量的审稿环节。

01 数据证实怀疑

怀疑需要证实。诺伊比格公开悬赏,寻求能够扫描所有会议投稿和评审意见以检测AI文本的人才。

专业AI文本检测公司Pangram Labs迅速响应了这一呼吁。

他们对ICLR 2026提交的19490篇研究和75800份评审进行了大规模扫描,结果令人震惊。

扫描数据显示,约21%的同行评审(15899份)被判定为完全由AI生成,超过一半的评审含有AI使用的迹象。

甚至投稿论文本身也未能幸免:1%(199篇)被判定为完全AI生成,9%的投稿包含超过50%的AI生成文本。

“人们之前只是怀疑,但没有具体证据。”Pangram首席执行官马克斯·斯佩罗表示。他们的分析为学术界的疑虑提供了确凿的数据支撑。

02 学者遭遇困扰

丹麦哥本哈根大学的计算机科学家德斯蒙德·埃利奥特团队遭遇了令人啼笑皆非的评审。

评审人竟提到论文中根本不存在的数值结果,并据此给出了最低分,让论文命运悬于“接受与拒绝”的边缘。

埃利奥特表示:“它完全错过了论文的重点。”他的博士生直觉判断这像是大型语言模型的“杰作”。

当Pangram公布分析结果后,埃利奥特立刻查询了自己论文的评审情况,确认了那份可疑的评审确实被标记为“完全AI生成”。

更为棘手的是,这些AI生成的评审意见虽然大部分空洞无物,但偶尔又会夹杂着一些值得回应的有效评语,迫使作者不得不在大量“AI废话”中挖掘有价值的内容。

03 会议组织者紧急应对

面对大规模AI滥用,ICLR 2026组织方迅速行动,并发布了措辞强硬的声明。

会议高级项目主席、康奈尔大学的计算机科学家巴拉特·哈里哈兰承认,这是会议“首次大规模面临此问题”。

会议方明确,大量使用大语言模型写论文却不声明,将被直接拒稿。

“LLM胡编乱造、虚构文献、逻辑掉线?将被视为违反道德准则。”会议已启动AI检测工具与领域主席双轨核查机制。

针对评审环节,声明强调:用LLM写评审可以,但评审人对内容负全责。如果出现“瞎扯、虚构引用”,直接记违规,后果可能包括评审人自己投稿的论文被直接拒稿。

会议方还鼓励作者举报疑似AI生成的垃圾评审,并承诺在1-2周内公开处理结果。

04 繁荣背后的隐忧

这场风波揭示了AI学术界繁荣背后的隐忧。ICLR 2026每位评审平均需在两周内审完5篇论文,“这远高于过去的工作量”。

“过去五年,AI领域呈指数级扩张,我们正面临评审危机。”诺伊比格道出了同行评审系统承受的巨大压力。

颇具讽刺意味的是,就在一年前,ICLR 2025还曾大规模引入AI辅助审稿,当时有12222条AI建议被审稿人采纳,89%的情况下提升了评审质量。

当时会议组织者称赞AI“提升了评审质量”,而如今却面临着AI泛滥成灾的窘境。

05 学术生态的挑战

一些作者因评审中的虚假陈述已被迫撤稿。更多人则在苦恼:如何回应这些充满“AI风格”的评审?

埃利奥特的经验颇具代表性:“疑似AI生成的评审往往包含‘大量内容’。”其中一部分或许相关值得回应,但另一部分则完全“毫无意义”。

在信息洪流中辨别有效反馈,成了研究者的新负担。

与此同时,其他AI顶会也面临着投稿量暴增的困境。NeurIPS 2025收到了近3万篇投稿,AAAI 2026更是收到了破纪录的约2.9万份投稿。

如此大量的投稿进一步加剧了审稿人的负担,形成了恶性循环。

会议组织者现在表示,他们将使用自动化工具评估提交的论文和评审是否违反了关于使用AI的政策。

但这样的措施能否真正堵住漏洞,仍是未知数。

一位研究人员在社交媒体上感叹:“当审稿人都不再阅读论文,科学同行评审的核心价值还剩下什么?”

关注 “悠AI” 更多干货技巧行业动态

相关文章