一款参数仅2B到8B的多模态模型,却在106个数据集中表现出色,甚至在复杂推理任务上比肩GPT-4o,SAIL-VL2正重新定义人工智能的“大小之争”。

抖音SAIL团队与新加坡国立大学LV-NUS实验室联合推出新一代多模态大模型SAIL-VL2,它以2B和8B的中小参数规模,在多项测试中超越了同规模模型,甚至与更大规模的闭源模型相媲美。

这款模型在MMMU、MathVista等需要复杂推理的基准测试中表现尤为出色。其8B思维增强版本在OpenCompass多模态推理榜单上平均得分54.4,仅次于GPT-4o-latest(54.8),超越所有开源模型。

01 小身材,大智慧

在人工智能领域,参数规模常被等同于模型能力,各大厂商纷纷推出千亿级参数的“巨无霸”模型。

然而,抖音SAIL团队与LV-NUS实验室选择了一条不同的道路——打造精巧而高效的SAIL-VL2模型。

SAIL-VL2提供的2B和8B两种参数规格,在106个多模态数据集上实现了性能突破。

其中,2B模型在4B参数以下开源模型中排名第一,证明了“小而精”的可行性。

在科技领域,效率往往是普及的关键。SAIL-VL2的小参数规模意味着它可以在更普通的硬件上运行,为更多开发者和企业降低了使用门槛。

02 三大创新突破

SAIL-VL2的成功并非偶然,而是源于在数据、训练和架构上的三大核心创新。

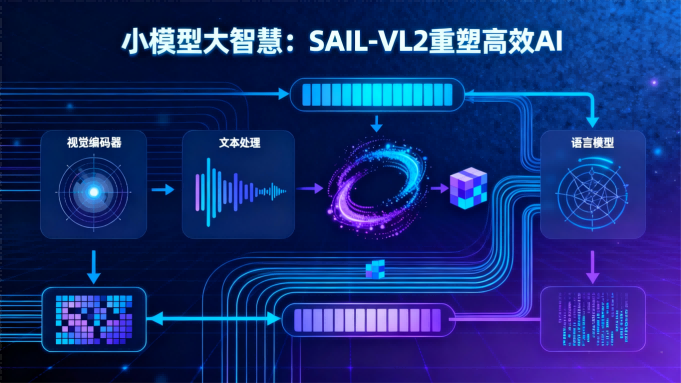

架构上,SAIL-VL2引入了稀疏混合专家(MoE)系统,优化了性能与计算效率的平衡。

其视觉编码器SAIL-ViT采用渐进式优化,逐步提升视觉与语言的对齐能力。

更值得一提的是SAIL-ViT-AnyRes技术,它打破了传统ViT的固定分辨率限制,借助“2D RoPE插值”技术,支持最高1792×1792的任意分辨率输入。

数据层面,研究团队构建了高质量的多模态语料库,通过评分过滤和合成增强手段,确保数据的准确性和多样性。

他们开发了全自动数据pipeline,通过“视觉信息丰富度”与“图文对齐度”双维度评分,过滤低质量样本。

训练策略上,团队设计了一套渐进式的五阶段后训练策略,从基础SFT开始,逐步过渡到LongCoT SFT、可验证奖励RL等阶段。

这种循序渐进的训练方式,让模型系统性地提升综合能力。

03 实际性能表现

SAIL-VL2的实际性能表现令人印象深刻。

根据测试结果,SAIL-VL2-2B在OpenCompass上的得分为70.31,超越了Qwen2.5-VL-3B(65.36)、InternVL3.5-2B(66.64)等模型,位列4B参数以下开源第一。

在细粒度任务上,SAIL-VL2-2B在MMStar测试中达到64.07分,OCRBench达到89.50分,均为同参数规模中最优。

更令人惊讶的是,SAIL-VL2-8B-Thinking在复杂推理任务上的表现已经接近最新的GPT-4o水平,而SAIL-VL2-A3B-Thinking以仅3B的激活参数,实现了53.6的分数。

它超越了闭源模型Gemini-2.0-Flash(50.6),展现出极高的效率性能比。

04 开源与可及性

SAIL-VL2作为开源项目,其模型与推理代码已经公开,这一举措无疑将推动多模态人工智能技术的发展和普及。

研究者与开发者可以在GitHub和Hugging Face平台上获取相关资源。

开源共享降低了技术门槛,让更多人可以基于这一先进模型进行进一步的研究和开发,促进创新生态的繁荣。

同时,SAIL-VL2的小参数特性也使得其在实际部署中更具优势,能够在资源受限的环境中运行,为AI技术的普及应用提供了新的可能性。

SAIL-VL2的出现,标志着AI模型发展从一味追求参数规模,转向更注重效率与性能的平衡。它的成功证明了通过精细的数据处理、渐进式训练和架构优化,小模型也能具备强大的多模态理解和复杂推理能力。

随着SAIL-VL2等“小而精”的模型开源,人工智能技术有望走出实验室,在更多普通设备上运行,真正实现智能技术的普惠与普及。

关注 “悠AI” 更多干货技巧行业动态

相关文章